Difference between revisions of "Experiments and Hypothesis Testing (German)"

| (27 intermediate revisions by 3 users not shown) | |||

| Line 1: | Line 1: | ||

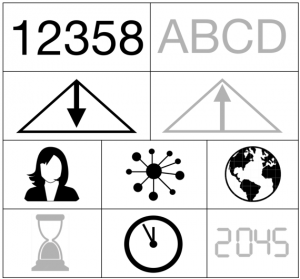

| + | [[File:Quan dedu indi syst glob pres.png|thumb|right|[[Design Criteria of Methods|Method Categorisation:]]<br> | ||

| + | '''Quantitative''' - Qualitative<br> | ||

| + | '''Deductive''' - Inductive<br> | ||

| + | '''Individual''' - '''System''' - '''Global'''<br> | ||

| + | Past - '''Present''' - Future]] | ||

'''Note:''' This is the German version of this entry. The original, English version can be found here: [[Experiments and Hypothesis Testing]]. This entry was translated using DeepL and only adapted slightly. Any etymological discussions should be based on the English text. | '''Note:''' This is the German version of this entry. The original, English version can be found here: [[Experiments and Hypothesis Testing]]. This entry was translated using DeepL and only adapted slightly. Any etymological discussions should be based on the English text. | ||

| − | + | '''Note:''' Dieser Eintrag stellt eine kurze Einführung zu Experimenten dar. Für weitere Informationen siehe [[Experiments]], [[Case studies and Natural experiments]] und [[Field experiments]]. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | '''Kurz und knapp:''' | + | '''Kurz und knapp:''' Dieser Eintrag stellt das Konzept von Hypothesen vor und zeigt, wie man sie systematisch testen kann. |

== Hypothesenentwicklung == | == Hypothesenentwicklung == | ||

[[File:James Lind, A Treatise on the Scurvy, 1757 Wellcome M0013130.jpg|thumb|James Linds "A Treatise on Scurvy", in dem er systematisch ergründet, was das beste Mittel gegen Skorbut ist.]] | [[File:James Lind, A Treatise on the Scurvy, 1757 Wellcome M0013130.jpg|thumb|James Linds "A Treatise on Scurvy", in dem er systematisch ergründet, was das beste Mittel gegen Skorbut ist.]] | ||

| − | '''Das Leben ist voller Hypothesen.'' | + | '''Das Leben ist voller Hypothesen.''' Wir werden alle durch einen [https://www.youtube.com/watch?v=HZ9xZHWY0mw endlosen Fluss von Fragen] verwirrt. Wir testen unsere Umgebung ständig auf mögliche "Was-wäre-wenn"-Fragen, die unseren Verstand überfordern, doch noch häufiger ist unser überladener Kopf nicht in der Lage, verallgemeinerbares Wissen zu produzieren. Dennoch hilft uns unser Gehirn dabei, unsere Umgebung zu filtern, auch indem es ständig Fragen - oder Hypothesen - prüft, damit wir die Herausforderungen, denen wir uns stellen, besser bewältigen können. Es sind nicht die wirklich großen Fragen, die uns jeden Tag beschäftigen, aber diese kleinen Fragen halten uns in Bewegung. |

| − | |||

| − | |||

Haben Sie schon einmal in einem Restaurant das falsche Essen gewählt? Dann schreibt Ihr Gehirn eine kleine Notiz an sich selbst, und beim nächsten Mal wählen Sie etwas anderes aus. So können wir unsere Nische im Leben finden. Irgendwann jedoch [https://www.sciencedirect.com/science/article/pii/S0092867408009537 begannen die Menschen, Muster in ihrer Umgebung zu beobachten] und diese anderen Menschen mitzuteilen. Zusammenarbeit und Kommunikation waren unsere Mittel, um zu Gemeinschaften und viel später zu Gesellschaften zu werden. Das geht auf die Zeit vor den Anfängen des Menschen zurück und kann auch bei anderen Tieren beobachtet werden. Im Rahmen unserer Entwicklung wurde es zum Rückgrat unserer modernen Zivilisation - im Guten wie im Schlechten - als wir begannen, unsere Fragen systematisch zu testen. James Lind zum Beispiel führte einen dieser [https://journals.sagepub.com/doi/pdf/10.1177/014107680309601201 ersten systematische Ansätze] auf See durch und schaffte es, eine Heilung für die Krankheit Skorbut zu finden, die den Seeleuten im 18. viele Probleme bereitet hatte. | Haben Sie schon einmal in einem Restaurant das falsche Essen gewählt? Dann schreibt Ihr Gehirn eine kleine Notiz an sich selbst, und beim nächsten Mal wählen Sie etwas anderes aus. So können wir unsere Nische im Leben finden. Irgendwann jedoch [https://www.sciencedirect.com/science/article/pii/S0092867408009537 begannen die Menschen, Muster in ihrer Umgebung zu beobachten] und diese anderen Menschen mitzuteilen. Zusammenarbeit und Kommunikation waren unsere Mittel, um zu Gemeinschaften und viel später zu Gesellschaften zu werden. Das geht auf die Zeit vor den Anfängen des Menschen zurück und kann auch bei anderen Tieren beobachtet werden. Im Rahmen unserer Entwicklung wurde es zum Rückgrat unserer modernen Zivilisation - im Guten wie im Schlechten - als wir begannen, unsere Fragen systematisch zu testen. James Lind zum Beispiel führte einen dieser [https://journals.sagepub.com/doi/pdf/10.1177/014107680309601201 ersten systematische Ansätze] auf See durch und schaffte es, eine Heilung für die Krankheit Skorbut zu finden, die den Seeleuten im 18. viele Probleme bereitet hatte. | ||

| Line 31: | Line 20: | ||

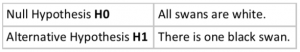

[[File:Bildschirmfoto 2020-01-17 um 11.18.08.png|thumb|left|Nullhypothese (H0) und Gegenhypothese (H1).]] | [[File:Bildschirmfoto 2020-01-17 um 11.18.08.png|thumb|left|Nullhypothese (H0) und Gegenhypothese (H1).]] | ||

| − | Konkrete Fragen, die in einer ersten Idee, einer Theorie, wurzeln, wurden so wiederholt getestet. Oder vielleicht sollte man besser sagen, dass diese Hypothesen mit Wiederholungen getestet wurden und die unsere Beobachtung störenden Einflüsse konstant gehalten wurden. Dies nennt man das Testen einer Hypothese: die wiederholte systematische Untersuchung einer vorgefassten Theorie, bei der während der Prüfung idealerweise alles konstant gehalten wird, außer dem, was untersucht wird. Während einige dies als die " | + | Konkrete Fragen, die in einer ersten Idee, einer Theorie, wurzeln, wurden so wiederholt getestet. Oder vielleicht sollte man besser sagen, dass diese Hypothesen mit Wiederholungen getestet wurden und die unsere Beobachtung störenden Einflüsse konstant gehalten wurden. Dies nennt man das '''Testen einer Hypothese''': die wiederholte systematische Untersuchung einer vorgefassten Theorie, bei der während der Prüfung idealerweise alles konstant gehalten wird, außer dem, was untersucht wird. Während einige dies als die "wissenschaftliche Methode" bezeichnen, gefällt mir diese Bezeichnung nicht besonders, da sie impliziert, dass es sich um DIE [https://www.khanacademy.org/science/high-school-biology/hs-biology-foundations/hs-biology-and-the-scientific-method/a/the-science-of-biology wissenschaftliche Methode] handelt, was sicherlich nicht stimmt. Dennoch war die systematische Prüfung der Hypothese und der daraus resultierende Erkenntnisprozess zweifellos eine wissenschaftliche Revolution (weitere Informationen finden Sie [[History of Methods (German)|hier]]). |

| − | Wichtig in Bezug auf dieses Wissen ist die Vorstellung, dass eine bestätigte Hypothese darauf hinweist, dass etwas wahr ist, dass aber andere, bisher unbekannte Faktoren diese Hypothese später verfälschen können. Aus diesem Grund ermöglicht uns die Prüfung von Hypothesen eine Annäherung an das Wissen, wie viele argumentieren würden, mit einer gewissen Sicherheit, aber [https://www. | + | Wichtig in Bezug auf dieses Wissen ist die Vorstellung, dass eine bestätigte Hypothese darauf hinweist, dass etwas wahr ist, dass aber andere, bisher unbekannte Faktoren diese Hypothese später verfälschen können. Aus diesem Grund ermöglicht uns die Prüfung von Hypothesen eine Annäherung an das Wissen, wie viele argumentieren würden, mit einer gewissen Sicherheit, aber [https://www.britannica.com/topic/criterion-of-falsifiability wir werden nie wirklich etwas wissen]. Das scheint zwar etwas verwirrend, aber ein prominentes Beispiel kann dies vielleicht veranschaulichen. Bevor Australien entdeckt wurde, waren alle in Europa bekannten Schwäne weiß. Mit der Entdeckung Australiens, und zur Überraschung der damaligen Naturhistoriker*innen, wurden schwarze Schwäne entdeckt. Vor dieser Entdeckung hätte also jeder eine Hypothese aufgestellt: [https://www.youtube.com/watch?v=wf-sGqBsWv4 alle Schwäne sind weiß]. Dann wurde Australien entdeckt, und die Welt veränderte sich oder zumindest das Wissen der westlichen Kulturen über Schwäne. |

'''An diesem Punkt ist es wichtig zu wissen, dass es zwei Arten von Hypothesen gibt.''' Stellen wir uns vor, Sie nähmen an, es gäbe nicht nur weiße Schwäne auf der Welt, sondern auch schwarze Schwäne. Die Nullhypothese (H0) besagt, dass das nicht der Fall ist - alles bleibt so, wie wir es annahmen, bevor Sie mit Ihrer merkwürdigen Idee um die Ecke gekommen sind. Die Nullhypothese wäre also: alle Schwäne sind weiß. Die Alternativhypothese (H1) fordert diese Nullhypothese nun heraus: es gibt auch schwarze Schwäne. Das haben Sie ja behauptet. Wir gehen aber nicht sofort davon aus dass das, was Sie behaupten, auch stimmt, also machen wir es zur Alternativhypothese. Jetzt wollen wir herausfinden, ob es eine ausreichende Beweislast zugunsten der Alternativhypothese gibt. Hierfür testen wir die Wahrscheinlichkeit, dass die H0 wahr ist, um zu entscheiden, ob wir H0 akzeptieren oder sie verwerfen und uns stattdessen für die H1 entscheiden. Diese Entscheidung geht Hand in Hand: wenn wir eine der beiden Hypothesen akzeptieren, weisen wir gleichzeitig die andere zurück. Achtung: Hypothesen kann man nur zurückweisen, nicht aber basierend auf Daten bestätigen. Wenn es heißt, dass eine Hypothese 'akzeptiert' oder 'verifiziert' oder 'bewiesen' wird, heißt das nur, dass die Alternative nicht unterstützt werden kann, und dass wir deshalb bei der wahrscheinlicheren Hypothese bleiben. | '''An diesem Punkt ist es wichtig zu wissen, dass es zwei Arten von Hypothesen gibt.''' Stellen wir uns vor, Sie nähmen an, es gäbe nicht nur weiße Schwäne auf der Welt, sondern auch schwarze Schwäne. Die Nullhypothese (H0) besagt, dass das nicht der Fall ist - alles bleibt so, wie wir es annahmen, bevor Sie mit Ihrer merkwürdigen Idee um die Ecke gekommen sind. Die Nullhypothese wäre also: alle Schwäne sind weiß. Die Alternativhypothese (H1) fordert diese Nullhypothese nun heraus: es gibt auch schwarze Schwäne. Das haben Sie ja behauptet. Wir gehen aber nicht sofort davon aus dass das, was Sie behaupten, auch stimmt, also machen wir es zur Alternativhypothese. Jetzt wollen wir herausfinden, ob es eine ausreichende Beweislast zugunsten der Alternativhypothese gibt. Hierfür testen wir die Wahrscheinlichkeit, dass die H0 wahr ist, um zu entscheiden, ob wir H0 akzeptieren oder sie verwerfen und uns stattdessen für die H1 entscheiden. Diese Entscheidung geht Hand in Hand: wenn wir eine der beiden Hypothesen akzeptieren, weisen wir gleichzeitig die andere zurück. Achtung: Hypothesen kann man nur zurückweisen, nicht aber basierend auf Daten bestätigen. Wenn es heißt, dass eine Hypothese 'akzeptiert' oder 'verifiziert' oder 'bewiesen' wird, heißt das nur, dass die Alternative nicht unterstützt werden kann, und dass wir deshalb bei der wahrscheinlicheren Hypothese bleiben. | ||

==== Fehler beim Testen einer Hypothese ==== | ==== Fehler beim Testen einer Hypothese ==== | ||

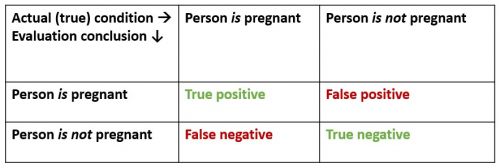

| − | [[File: | + | [[File:Type 1 type 2 error.jpg|500px|thumb|right|Verschiedene Arten von Fehlern bei Schwangerschaftstests.]] |

| − | Beim Testen von Hypothesen können | + | Beim Testen von Hypothesen können zwei verschiedene Fehler auftreten. Der falsch positive ("Fehlertyp I") und der falsch negative ("Fehlertyp II"). Wenn ein*e Ärzt*in bei einer Person eine Schwangerschaft diagnostiziert und diese Person nicht schwanger ist, handelt es sich um einen typischen falsch-positiven Fehler. Der*die Ärzt*in hat behauptet, dass die Person schwanger ist, was nicht der Fall ist. Umgekehrt ist es ein typischer falsch-negativer Fehler, wenn der*die Ärzt*in bei einer Person diagnostiziert, dass sie nicht schwanger ist, es aber tatsächlich ist - ein typischer falsch-negativer Fehler. Jede*r kann für sich selbst beurteilen, welche Art von Fehler gefährlicher ist. Dennoch sind beide Fehler zu vermeiden. Während der Corona-Krise wurde dies zu einem wichtigen Thema, da viele der Tests oft falsch waren. Wenn jemand Corona Symptome zeigte, aber negativ getestet wurde, war es ein falsches Negativ. Dies hängt anscheinend vom Zeitpunkt der Untersuchung und den jeweiligen Tests ab. Antikörpertests sind nur relevant, nachdem jemand Corona hatte, aber manchmal finden auch diese keine Antikörper. Bei einem aktiven Fall kann nur eine PCR eine Infektion bestätigen, aber die Entnahme einer Probe ist trickreich, daher gab es auch hier einige falsch-negative Ergebnisse. Falsch-positive Ergebnisse sind jedoch sehr selten, da die Fehlerquote des Tests auf dieser Seite sehr gering ist. Dennoch kam es manchmal vor, dass Proben verwechselt wurden. Selten, aber es kam vor, und sorgte für großes Aufsehen in den Medien. |

==== Wissen verändert sich mit der Zeit ==== | ==== Wissen verändert sich mit der Zeit ==== | ||

| − | In der modernen Wissenschaft wird große Sorgfalt darauf verwendet, Hypothesen zu konstruieren, die systematisch fundiert sind, was bedeutet, dass schwarze Schwäne nicht zu erwarten sind, aber manchmal nicht verhindert werden können. Ein Beispiel ist die Frage, ob ein Medikament für | + | In der modernen Wissenschaft wird große Sorgfalt darauf verwendet, Hypothesen zu konstruieren, die systematisch fundiert sind, was bedeutet, dass schwarze Schwäne nicht zu erwarten sind, aber manchmal nicht verhindert werden können. Ein Beispiel ist die Frage, ob ein Medikament für Schwangere geeignet ist. Aus ethischen Gründen wird dies kaum getestet, was in der Vergangenheit schwerwiegende negative Auswirkungen hatte. Das Wissen darüber, wie sich ein bestimmtes Medikament auf Schwangere auswirkt, beruht daher oft auf Erfahrungen, wird aber nicht systematisch untersucht. Zusammengenommen werden Hypothesen zu einer Grundlage der modernen Wissenschaft, obwohl sie nur ein Konzept innerhalb des breiten Kanons wissenschaftlicher Methoden darstellen. Die Abhängigkeit von [[:Category:Deductive|deduktiven]] Ansätzen hat in der Vergangenheit ebenfalls Probleme aufgeworfen und kann indirekt dazu führen, dass eine Mauer zwischen dem durch [[Design Criteria of Methods (German)|induktive vs. deduktive]] Ansätze geschaffenen Wissen errichtet wird. |

| + | |||

| + | ==== Ein Gegenmittel für COVID-19 ==== | ||

| + | Ein bekanntes Beispiel für strenge Experimente sind klinische Studien, die fast alle Impfstoffe, so wie auch die Impfstoffe gegen Covid-19, durchlaufen. Diese Studien testen sehr viele Hypothesen. Ist der Impfstoff für die Menschen sicher, gibt es keine Nebenwirkungen, allergische Reaktionen oder andere schweren medizinischen Probleme? Erzeugt der Impfstoff eine Immunantwort? Und wirkt er auf verschiedene Altersgruppen oder andere Gruppen unterschiedlich? Um diese Strategien sicher zu testen, haben sich in den letzten Jahrzehnten klinische Studien als Goldstandard in modernen Experimenten herauskristallisiert. Viele mögen die moderne Wissenschaft kritisieren und vieles von dem in Frage stellen, was die Wissenschaft getan hat, um nicht nur zu einer positiven Entwicklung in unserer Gesellschaft beizutragen. Dennoch verdanken viele von uns ihr Leben solchen klinischen Versuchen - der sicheren und soliden Prüfung wissenschaftlicher Hypothesen unter sehr reproduzierbaren Bedingungen. Ein großer Teil der modernen Medizin, der Psychologie, der Produkttests und auch der Landwirtschaft verdankt ihre Auswirkungen auf unsere Gesellschaften dem Experiment. Im Nachhinein betrachtet können Impfungen als der sicherste Weg angesehen werden, die Covid-19-Pandemie zu beenden. Wir haben nicht nur diese Hypothese, sondern waren auch in der Lage sie in einem bestimmten, begrenzten Zeitrahmen bis heute zu testen. Die wissenschaftlichen Studien zeigen in eine klare Richtung, aber es gibt immer noch langfristigere Untersuchungen für diese Pandemie, die weiterhin unsere Hypothese untersuchen. | ||

==== Key messages ==== | ==== Key messages ==== | ||

| Line 50: | Line 42: | ||

* Es gibt zwei verschiedene Fehler, die auftreten können: falsch positiv ("Fehlertyp I") und falsch negativ ("Fehlertyp II"). | * Es gibt zwei verschiedene Fehler, die auftreten können: falsch positiv ("Fehlertyp I") und falsch negativ ("Fehlertyp II"). | ||

| − | |||

| − | |||

| − | |||

== Validität == | == Validität == | ||

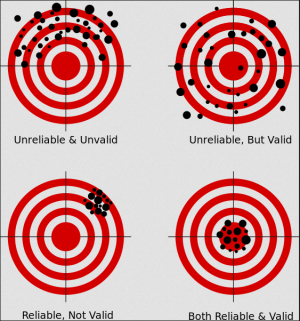

[[File:Bildschirmfoto 2020-04-24 um 12.42.47.png|thumb|Das bekannte Darts-Beispiel, das die Beziehung zwischen Validität und Realiabilität aufzeigt. Das Bull-Eye stellt die Genauigkeit unserer Messung dar (Validität) während die Position der Pfeile die Genauigkeit unserer Treffer darstellt (Reliabilität).]] | [[File:Bildschirmfoto 2020-04-24 um 12.42.47.png|thumb|Das bekannte Darts-Beispiel, das die Beziehung zwischen Validität und Realiabilität aufzeigt. Das Bull-Eye stellt die Genauigkeit unserer Messung dar (Validität) während die Position der Pfeile die Genauigkeit unserer Treffer darstellt (Reliabilität).]] | ||

| − | Validität leitet sich vom lateinischen Wort "validus" ab, das mit "stark" übersetzt wird. Es handelt sich somit um ein | + | Validität leitet sich vom lateinischen Wort "validus" ab, das mit "stark" übersetzt wird. Es handelt sich somit um ein zentrales Konzept innerhalb der Hypothesenprüfung, da es qualifiziert, inwieweit eine Hypothese wahr ist. Seine Bedeutung sollte nicht mit der Reliabilität verwechselt werden, die angibt, ob bestimmte Ergebnisse konsistent oder, mit anderen Worten, reproduzierbar sind. Die Validität gibt vielmehr an, inwieweit eine Hypothese bestätigt werden kann. Folglich ist sie zentral für den deduktiven Ansatz in der Wissenschaft; mit anderen Worten: sie sollte nicht über diese Denkweise hinaus missbraucht werden. Die Validität ist daher stark mit der Argumentation verbunden, weshalb sie die Gesamtstärke des Ergebnisses eines statistischen Resultats angibt. |

| − | Wir sollten uns jedoch bewusst sein, dass die Validität den | + | Wir sollten uns jedoch bewusst sein, dass die Validität den gesamten Prozess der Anwendung von Statistik umfasst. '''Validität erstreckt sich von der Postulierung der ursprünglichen Hypothese über das methodische Design, die Wahl der Analyse und schließlich bis zur Interpretation.''' Die Validität ist also kein "alles oder nichts". Stattdessen müssen wir die verschiedenen Ansätze und [https://explorable.com/statistical-validity Geschmacksrichtungen der Validität] kennen lernen, und nur die Erfahrung mit verschiedenen Datensätzen und Situationen wird es uns ermöglichen zu beurteilen, ob ein Ergebnis gültig ist oder nicht. Man kann zum Beispiel vorhersagen, dass es wahrscheinlicher ist, dass jemand gähnt, wenn andere Personen in der Umgebung auch gähnen, da Gähnen ansteckend ist. Das sagt aber nichts darüber aus, wie müde jemand ist oder warum. Gähnen könnte daher auch nur dann ein valides Maß für Müdigkeit sein, wenn Menschen alleine sind. Ob Gähnen ein valides Maß für Müdigkeit ist, hängt also vom Kontext ab und ist generell nicht sehr valide. Folglich ist die Validität der Frage, ob die Bestätigung einer Hypothese vernünftig ist, viel schwieriger zu beantworten, denn wir könnten voreingenommen oder schlichtweg nicht dazu in der Lage sein, den Kontext zu verstehen, wenn wir eine Studie erstellt haben. Nehmen Sie sich Zeit, um etwas über die Validität zu lernen, und nehmen Sie sich noch mehr Zeit, um Erfahrungen darüber zu sammeln, ob ein Ergebnis valide ist. |

== Reliabilität == | == Reliabilität == | ||

| − | [https://www.scribbr.com/methodology/reliability-vs-validity/ Reliabilität] ist eines der Schlüsselkonzepte der Statistik. Sie ist definiert als die Konsistenz eines bestimmten Maßes. '''Eine zuverlässige Messung liefert also vergleichbare Ergebnisse unter den gleichen Bedingungen.''' Die Reliabilität gibt Ihnen eine Vorstellung davon, ob Ihre Analyse unter den gegebenen Bedingungen genau und auch reproduzierbar ist. Wir haben bereits gelernt, dass die meisten, wenn nicht sogar alle Maße in der Statistik konstruiert sind. Reliabilität ist von zentraler Bedeutung, da wir überprüfen können, ob unsere konstruierten Maße uns auf den richtigen Weg bringen. Mit anderen Worten, die Reliabilität ermöglicht es uns zu verstehen, ob unsere konstruierten Maße funktionieren. | + | [https://www.scribbr.com/methodology/reliability-vs-validity/ Reliabilität] ist eines der Schlüsselkonzepte der Statistik. Sie ist definiert als die Konsistenz eines bestimmten Maßes. '''Eine zuverlässige Messung liefert also vergleichbare Ergebnisse unter den gleichen Bedingungen.''' Die Reliabilität gibt Ihnen eine Vorstellung davon, ob Ihre Analyse unter den gegebenen Bedingungen genau und auch reproduzierbar ist. Wir haben bereits gelernt, dass die meisten, wenn nicht sogar alle Maße in der Statistik, konstruiert sind. Reliabilität ist von zentraler Bedeutung, da wir überprüfen können, ob unsere konstruierten Maße uns auf den richtigen Weg bringen. Mit anderen Worten, die Reliabilität ermöglicht es uns zu verstehen, ob unsere konstruierten Maße funktionieren. |

Die Frage der [https://explorable.com/statistical-reliability Reproduzierbarkeit], die mit der Reliabilität verbunden ist, ist ein [https://www.youtube.com/watch?v=m0W8nnupcUk zentraler Aspekt der modernen Wissenschaft]. Reliabilität ist daher das Konzept, das mindestens mehrere Komponenten enthält. | Die Frage der [https://explorable.com/statistical-reliability Reproduzierbarkeit], die mit der Reliabilität verbunden ist, ist ein [https://www.youtube.com/watch?v=m0W8nnupcUk zentraler Aspekt der modernen Wissenschaft]. Reliabilität ist daher das Konzept, das mindestens mehrere Komponenten enthält. | ||

| − | 1. Das Ausmaß und die Komplexität des Maßes, das wir in unsere Analyse einbeziehen. Zwar kann im Allgemeinen nicht davon ausgegangen werden, dass [[To Rule And To Measure (German)|extrem konstruierte Maße wie das BIP oder der IQ]] weniger zuverlässig sind als weniger konstruierte, aber wir sollten dennoch Occams Rasiermesser berücksichtigen, wenn wir über die Zuverlässigkeit von Maßen nachdenken, d.h. | + | 1. Das Ausmaß und die Komplexität des Maßes, das wir in unsere Analyse einbeziehen. Zwar kann im Allgemeinen nicht davon ausgegangen werden, dass [[To Rule And To Measure (German)|extrem konstruierte Maße wie das BIP oder der IQ]] weniger zuverlässig sind als weniger konstruierte, aber wir sollten dennoch Occams Rasiermesser berücksichtigen, wenn wir über die Zuverlässigkeit von Maßen nachdenken, d.h. ihre Konstrukte kurz und einfach halten. |

2. Relevant für die Reliabilität ist die Frage nach unserer Stichprobe. Wenn sich die äußeren Bedingungen der Stichprobe ändern, kann die Reliabilität aufgrund neuer Informationen abnehmen. Ein einfaches Beispiel wären wieder Schwäne. Wenn wir feststellen, dass es nur weiße Schwäne gibt, ist diese Hypothese zuverlässig, solange es nur weiße Schwäne in der Stichprobe gibt. Wenn sich jedoch die äußeren Bedingungen ändern - zum Beispiel wenn wir schwarze Schwäne in Australien entdecken - nimmt die Reliabilität unserer ersten Hypothese ab. | 2. Relevant für die Reliabilität ist die Frage nach unserer Stichprobe. Wenn sich die äußeren Bedingungen der Stichprobe ändern, kann die Reliabilität aufgrund neuer Informationen abnehmen. Ein einfaches Beispiel wären wieder Schwäne. Wenn wir feststellen, dass es nur weiße Schwäne gibt, ist diese Hypothese zuverlässig, solange es nur weiße Schwäne in der Stichprobe gibt. Wenn sich jedoch die äußeren Bedingungen ändern - zum Beispiel wenn wir schwarze Schwäne in Australien entdecken - nimmt die Reliabilität unserer ersten Hypothese ab. | ||

| − | 3. Darüber hinaus kann auch die Probenahme beeinträchtigt werden. Wenn die Beprobung von mehreren Beobachtern durchgeführt wird, kann eine Verringerung der Reliabilität durch die Unterschiede der jeweiligen | + | 3. Darüber hinaus kann auch die Probenahme beeinträchtigt werden. Wenn die Beprobung von mehreren Beobachtern durchgeführt wird, kann eine Verringerung der Reliabilität durch die Unterschiede der jeweiligen Beobachtenden erklärt werden. |

4. Wir müssen erkennen, dass unterschiedliche methodische Ansätze - oder in unserem Fall statistische Tests - aus unterschiedlichen Reliabilitätsmaßen bestehen können. Daher könnte sich das statistische Modell unserer Analyse direkt in unterschiedlichen Reliabilitäten niederschlagen. Ein einfaches Beispiel, um dies etwas besser zu erklären, ist der Ein-Stichproben-Test mit einer perfekten Münze. Dieser Test sollte funktionieren, aber er funktioniert nicht mehr, wenn die Münze verzerrt ist. Dann müssen wir eine neue Methode/Modell in Betracht ziehen, um dies zu erklären (nämlich den "Zwei-Stichproben-Test"). Wichtig ist, sich daran zu erinnern: Die Wahl Ihrer Methode/Modell hat einen Einfluss auf Ihre Testergebnisse. | 4. Wir müssen erkennen, dass unterschiedliche methodische Ansätze - oder in unserem Fall statistische Tests - aus unterschiedlichen Reliabilitätsmaßen bestehen können. Daher könnte sich das statistische Modell unserer Analyse direkt in unterschiedlichen Reliabilitäten niederschlagen. Ein einfaches Beispiel, um dies etwas besser zu erklären, ist der Ein-Stichproben-Test mit einer perfekten Münze. Dieser Test sollte funktionieren, aber er funktioniert nicht mehr, wenn die Münze verzerrt ist. Dann müssen wir eine neue Methode/Modell in Betracht ziehen, um dies zu erklären (nämlich den "Zwei-Stichproben-Test"). Wichtig ist, sich daran zu erinnern: Die Wahl Ihrer Methode/Modell hat einen Einfluss auf Ihre Testergebnisse. | ||

| − | 5. Der letzte Aspekt der Reliabilität hängt mit unserer theoretischen Grundlage selbst zusammen. Wenn unsere zugrundeliegende Theorie revidiert oder geändert wird, kann dies die Zuverlässigkeit unserer Ergebnisse insgesamt beeinträchtigen. Es ist wichtig, dies hervorzuheben, da wir innerhalb einer gegebenen statistischen Analyse eine insgesamt bessere theoretische Grundlage haben könnten, das statistische Maß der Reliabilität jedoch niedriger sein könnte. Dies ist eine Quelle ständiger Verwirrung unter Statistik- | + | 5. Der letzte Aspekt der Reliabilität hängt mit unserer theoretischen Grundlage selbst zusammen. Wenn unsere zugrundeliegende Theorie revidiert oder geändert wird, kann dies die Zuverlässigkeit unserer Ergebnisse insgesamt beeinträchtigen. Es ist wichtig, dies hervorzuheben, da wir innerhalb einer gegebenen statistischen Analyse eine insgesamt bessere theoretische Grundlage haben könnten, das statistische Maß der Reliabilität jedoch niedriger sein könnte. Dies ist eine Quelle ständiger Verwirrung unter Statistik-Lernenden. Zum Beispiel versuchen Ökonomen immer noch, wirtschaftliche Dynamiken auf Basis des Bruttoinlandsproduktes zu modellieren. Wenn wir diese Annahme hin zu einer differenzierteren Theorie erneuern, könnte unser Modell schlechter funktionieren, aber wir würden die wirtschaftlichen Dynamiken trotzdem weniger falsch verstehen. |

| − | Die Frage, wie zuverlässig eine statistische Analyse oder besser das Ergebnis einer wissenschaftlichen Studie ist, ist meiner Erfahrung nach die Quelle endloser Debatten. Es gibt kein [https://www.statisticssolutions.com/directory-of-statistical-analyses-reliability-analysis/ Maß der Reliabilität], das von allen akzeptiert wird. Stattdessen entwickelt sich die Statistik immer noch weiter, und die Maße der Zuverlässigkeit ändern sich. Auch wenn dies auf den ersten Blick verwirrend erscheint, sollten wir zwischen Ergebnissen, die extrem reliabel sind, und Ergebnissen, die in Bezug auf die Reliabilität geringer sind, unterscheiden. [https://opinionator.blogs.nytimes.com/2012/05/17/how-reliable-are-the-social-sciences/ Ergebnisse aus der harten Wissenschaft] wie Physik zeigen oft eine hohe Reliabilität, wenn es um statistische Tests geht, während weiche Wissenschaften wie Psychologie und Wirtschaft am unteren Ende der Reliabilität zu finden sind. Das ist keine normative Beurteilung, da die moderne Medizin oft Ergebnisse liefert, die zuverlässig sind, aber nur gerade so. Denken Sie an die Krebsforschung. Die meisten aktuellen Durchbrüche verändern das Leben einiger weniger Prozent der | + | Die Frage, wie zuverlässig eine statistische Analyse oder besser das Ergebnis einer wissenschaftlichen Studie ist, ist meiner Erfahrung nach die Quelle endloser Debatten. Es gibt kein [https://www.statisticssolutions.com/directory-of-statistical-analyses-reliability-analysis/ Maß der Reliabilität], das von allen akzeptiert wird. Stattdessen entwickelt sich die Statistik immer noch weiter, und die Maße der Zuverlässigkeit ändern sich. Auch wenn dies auf den ersten Blick verwirrend erscheint, sollten wir zwischen Ergebnissen, die extrem reliabel sind, und Ergebnissen, die in Bezug auf die Reliabilität geringer sind, unterscheiden. [https://opinionator.blogs.nytimes.com/2012/05/17/how-reliable-are-the-social-sciences/ Ergebnisse aus der harten Wissenschaft] wie Physik zeigen oft eine hohe Reliabilität, wenn es um statistische Tests geht, während weiche Wissenschaften wie Psychologie und Wirtschaft am unteren Ende der Reliabilität zu finden sind. Das ist keine normative Beurteilung, da die moderne Medizin oft Ergebnisse liefert, die zuverlässig sind, aber nur gerade so. Denken Sie an die Krebsforschung. Die meisten aktuellen Durchbrüche verändern das Leben einiger weniger Prozent der Patient*innen, und es gibt kaum einen Durchbruch, der einen größeren Teil der Patient*innen betrifft. Wir müssen daher die Zuverlässigkeit in der Statistik als ein bewegliches Ziel akzeptieren, und es hängt sehr stark vom Kontext ab, ob ein Ergebnis eine hohe oder niedrige Zuverlässigkeit hat. |

== Unsicherheit == | == Unsicherheit == | ||

| Line 85: | Line 74: | ||

Während die Validität alles von der Theoriebildung bis zur endgültigen Bestätigung umfasst, beschäftigt sich die Unsicherheit nur mit der methodologischen Dimension des Hypothesentests. Beobachtungen können fehlerhaft sein, Messungen können falsch sein, eine Analyse kann verzerrt und falsch ausgewählt sein, aber das ist es zumindest, was uns die Unsicherheit sagen kann. [https://www.visionlearning.com/en/library/Process-of-Science/49/Uncertainty-Error-and-Confidence/157 '''Unsicherheit] ist daher ein Wort für alle Fehler, die innerhalb einer methodologischen Anwendung gemacht werden können.''' Besser noch, Unsicherheit kann uns somit den Unterschied zwischen einem perfekten Modell und unseren empirischen Ergebnissen aufzeigen. Die Unsicherheit ist wichtig, um zu erkennen, wie gut unsere Hypothese oder unser Modell durch empirische Daten bestätigt werden kann, und alle damit verbundenen Messfehler und Fehlauswahlen in der Analyse. | Während die Validität alles von der Theoriebildung bis zur endgültigen Bestätigung umfasst, beschäftigt sich die Unsicherheit nur mit der methodologischen Dimension des Hypothesentests. Beobachtungen können fehlerhaft sein, Messungen können falsch sein, eine Analyse kann verzerrt und falsch ausgewählt sein, aber das ist es zumindest, was uns die Unsicherheit sagen kann. [https://www.visionlearning.com/en/library/Process-of-Science/49/Uncertainty-Error-and-Confidence/157 '''Unsicherheit] ist daher ein Wort für alle Fehler, die innerhalb einer methodologischen Anwendung gemacht werden können.''' Besser noch, Unsicherheit kann uns somit den Unterschied zwischen einem perfekten Modell und unseren empirischen Ergebnissen aufzeigen. Die Unsicherheit ist wichtig, um zu erkennen, wie gut unsere Hypothese oder unser Modell durch empirische Daten bestätigt werden kann, und alle damit verbundenen Messfehler und Fehlauswahlen in der Analyse. | ||

| − | Was die Unsicherheit so praktisch macht, ist die Tatsache, dass viele statistische Analysen über ein Maß zur Quantifizierung der Unsicherheit verfügen, und durch wiederholte Stichproben können wir so den so genannten "Fehler" unseres statistischen Tests | + | Was die Unsicherheit so praktisch macht, ist die Tatsache, dass viele statistische Analysen über ein Maß zur Quantifizierung der Unsicherheit verfügen, und durch wiederholte Stichproben können wir so den so genannten "Fehler" unseres statistischen Tests abschätzen. Das [https://www.youtube.com/watch?v=tFWsuO9f74o Konfidenzintervall] ist ein klassisches Beispiel für eine solche Quantifizierung eines Fehlers eines statistischen Ergebnisses. Da es eng mit der Wahrscheinlichkeit verbunden ist, kann uns das Konfidenzintervall die Wahrscheinlichkeit sagen, mit der unsere Ergebnisse reproduzierbar sind. Dies klingt zwar wie ein kleines Detail, ist aber in der modernen Statistik von enormer Bedeutung. Die Unsicherheit erlaubt es uns, zu quantifizieren, ob eine bestimmte Analyse zuverlässig wiederholt werden kann und das Ergebnis unter vergleichbaren Bedingungen relevant sein kann. |

| − | Nehmen wir das Beispiel einer medizinischen Behandlung, bei der eine hohe Unsicherheit identifiziert wird. Würden Sie sich dem Verfahren unterziehen? Niemand, der bei klarem Verstand ist, würde einer Behandlung vertrauen, die mit einer hohen Unsicherheit behaftet ist. Daher wurde die Unsicherheit zur Grundlinie des wissenschaftlichen Ergebnisses in der quantitativen Wissenschaft. Es ist zu beachten, dass dies auch Missbrauch und Korruption Tür und Tor öffnete. Viele Wissenschaftler messen ihre wissenschaftlichen Verdienste an ihrem Modell mit der geringsten Unsicherheit, und so mancher Missbrauch wurde durch die grenzenlose Suche nach der Bewältigung der Unsicherheit betrieben. Wir müssen uns jedoch bewusst sein, dass falsch verstandene Statistiken und schwere Fälle von wissenschaftlichem Fehlverhalten eine Ausnahme und nicht die Norm sind. Wenn wissenschaftliche Ergebnisse veröffentlicht werden, können wir sie in Frage stellen, aber wir können nicht ihre soliden und sicheren | + | Nehmen wir das Beispiel einer medizinischen Behandlung, bei der eine hohe Unsicherheit identifiziert wird. Würden Sie sich dem Verfahren unterziehen? Niemand, der bei klarem Verstand ist, würde einer Behandlung vertrauen, die mit einer hohen Unsicherheit behaftet ist. Daher wurde die Unsicherheit zur Grundlinie des wissenschaftlichen Ergebnisses in der quantitativen Wissenschaft. Es ist zu beachten, dass dies auch Missbrauch und Korruption Tür und Tor öffnete. Viele Wissenschaftler*innen messen ihre wissenschaftlichen Verdienste an ihrem Modell mit der geringsten Unsicherheit, und so mancher Missbrauch wurde durch die grenzenlose Suche nach der Bewältigung der Unsicherheit betrieben. Wir müssen uns jedoch bewusst sein, dass falsch verstandene Statistiken und schwere Fälle von wissenschaftlichem Fehlverhalten eine Ausnahme und nicht die Norm sind. Wenn wissenschaftliche Ergebnisse veröffentlicht werden, können wir sie in Frage stellen, aber wir können nicht ihre soliden und sicheren Maße in Frage stellen, die sich über Jahrzehnte hinweg etabliert haben. Unsicherheit kann immer noch ein Leitfaden sein, der uns hilft, die Wahrscheinlichkeit zu bestimmen, mit der unsere Ergebnisse einer bestimmten Realität entsprechen. |

== Die Geschichte des Laborexperiments == | == Die Geschichte des Laborexperiments == | ||

| Line 98: | Line 87: | ||

[[File:Bike repair 1.jpg|thumb|left|Etwas ins Grüne hinein auszuprobieren ist nicht mit einem systematischen wissenschaftlichen Experiment gleichzusetzen.]] | [[File:Bike repair 1.jpg|thumb|left|Etwas ins Grüne hinein auszuprobieren ist nicht mit einem systematischen wissenschaftlichen Experiment gleichzusetzen.]] | ||

| − | Aufgrund des Bedarfs an systematischem Wissen reiften einige Disziplinen heran, sodass eigene Abteilungen gegründet wurden, einschließlich der notwendigen Laborräume zur Durchführung von [https://www.tutor2u.net/psychology/reference/laboratory-experiments Experimenten]. Das Hauptaugenmerk lag dabei auf der Durchführung möglichst reproduzierbarer Experimente, d.h. im Idealfall mit 100%iger | + | Aufgrund des Bedarfs an systematischem Wissen reiften einige Disziplinen heran, sodass eigene Abteilungen gegründet wurden, einschließlich der notwendigen Laborräume zur Durchführung von [https://www.tutor2u.net/psychology/reference/laboratory-experiments Experimenten]. Das Hauptaugenmerk lag dabei auf der Durchführung möglichst reproduzierbarer Experimente, d.h. im Idealfall mit 100%iger Konfidenz. Die Laborbedingungen zielten also darauf ab, konstante Bedingungen zu schaffen und idealerweise nur einen oder wenige Parameter zu manipulieren, die damit systematisch getestet werden konnten. Notwendige Wiederholungen wurden ebenfalls durchgeführt, was aber zu diesem Zeitpunkt von geringerer Bedeutung war. Viele der frühen Experimente waren daher eher einfache Experimente, die aber zu verallgemeinerbaren Erkenntnissen führten. Es gab auch eine allgemeine Tendenz, dass Experimente entweder funktionierten oder nicht, was bis heute eine Quelle großer Verwirrung ist, da ein [https://www.psychologydiscussion.net/learning/learning-theory/thorndikes-trial-and-error-theory-learning-psychology/13469 'trial and error'-] Ansatz - obwohl er ein gültiger Ansatz ist - oft mit einem allgemeinen Modus des "Experimentierens" verwechselt wird. In diesem Sinne betrachten viele Menschen die Vorbereitung eines Fahrrads ohne jegliche Kenntnisse über Fahrräder als einen Modus des "Experimentierens". Wir betonen daher, dass Experimente systematisch sind. Der nächste große Schritt war die Bereitstellung von Gewissheit und Möglichkeiten zur Berechnung von Unsicherheit, die mit dem Aufkommen der Wahrscheinlichkeitsstatistik einherging. |

'''Zuerst in der Astronomie, dann aber auch in der Landwirtschaft und in anderen Bereichen wurde deutlich, dass reproduzierbare Bedingungen manchmal schwer zu erreichen sein können.''' Messfehler in der Astronomie waren ein weit verbreitetes Problem der Optik und anderer Apparate im 18. und 19. Jahrhundert, und Fisher erkannte ebenso die Unordnung - oder Varianz -, die die Natur einem systematischen Experimentator aufzwingt. Das Laborexperiment war daher ein wichtiger Schritt zu einer systematischen Untersuchung bestimmter Hypothesen, die durch neu etablierte statistische Ansätze untermauert wurde. | '''Zuerst in der Astronomie, dann aber auch in der Landwirtschaft und in anderen Bereichen wurde deutlich, dass reproduzierbare Bedingungen manchmal schwer zu erreichen sein können.''' Messfehler in der Astronomie waren ein weit verbreitetes Problem der Optik und anderer Apparate im 18. und 19. Jahrhundert, und Fisher erkannte ebenso die Unordnung - oder Varianz -, die die Natur einem systematischen Experimentator aufzwingt. Das Laborexperiment war daher ein wichtiger Schritt zu einer systematischen Untersuchung bestimmter Hypothesen, die durch neu etablierte statistische Ansätze untermauert wurde. | ||

| + | |||

| + | Mehr Informationen zum Laborexperiment finden Sie [[Experiments|hier]]. | ||

== Die Geschichte des Feldexperiments == | == Die Geschichte des Feldexperiments == | ||

[[File:Bildschirmfoto 2020-05-21 um 15.46.03.png|thumb|Feldexperimente wurden - wie man sich vielleicht denken kann - zuerst in der Landwirtschaft durchgeführt.]] | [[File:Bildschirmfoto 2020-05-21 um 15.46.03.png|thumb|Feldexperimente wurden - wie man sich vielleicht denken kann - zuerst in der Landwirtschaft durchgeführt.]] | ||

| − | Mit zunehmendem Wissensstand zeigte sich, dass die kontrollierte Einrichtung eines Labors nicht ausreichte. Zuerst in der Astronomie, dann aber auch in der Landwirtschaft und in anderen Bereichen wurde die Vorstellung deutlich, dass [https://sustainabilitymethods.org/index.php/Experiments#History_of_laboratory_experiments reproduzierbare Einstellungen manchmal schwer zu erreichen sein können]. Die Nachfrage nach mehr Nahrung aufgrund des Bevölkerungswachstums und die Verfügbarkeit potenter Saatgutsorten und Düngemittel - beides dank wissenschaftlicher Experimente möglich - warfen die Frage auf, wie man [https://explorable.com/field-experiments Experimente unter Feldbedingungen] durchführen sollte. Die Durchführung von Experimenten im Labor stieß an ihre äußeren Grenzen, da Pflanzenwachstumsexperimente in den kleinen, engen Räumen eines Labors schwer durchführbar waren, und es wurde in Frage gestellt, ob die Ergebnisse tatsächlich in der realen Welt anwendbar waren. Daher verlagerten sich die Experimente buchstäblich ins Feld, mit [https://www.tutor2u.net/psychology/reference/field-experimentsme dramatischen Auswirkungen auf ihre Gestaltung, Durchführung und Ergebnisse]. Während die Laborbedingungen darauf abzielten, die Varianz zu minimieren - im Idealfall wurden die Experimente mit hoher Zuverlässigkeit durchgeführt -, wurde bei den neuen Feldexperimenten die Stichprobengröße erhöht, um die Variabilität - oder Unordnung - von Faktoren zu zähmen, die nicht kontrolliert werden konnten, wie z.B. subtile Veränderungen des Bodens oder des Mikroklimas. [https://en.wikipedia.org/wiki/Field_experiment#Examples Die Etablierung des Feldexperiments] wurde so zu einem Schritt in der wissenschaftlichen Entwicklung, aber auch in der industriellen Entwicklung. Die Wissenschaft trug direkt zur Effizienz der Produktion bei, im Guten wie im Schlechten. | + | Mit zunehmendem Wissensstand zeigte sich, dass die kontrollierte Einrichtung eines Labors nicht ausreichte. Zuerst in der Astronomie, dann aber auch in der Landwirtschaft und in anderen Bereichen wurde die Vorstellung deutlich, dass [https://sustainabilitymethods.org/index.php/Experiments#History_of_laboratory_experiments reproduzierbare Einstellungen manchmal schwer zu erreichen sein können]. Beobachtungen können unzuverlässig sein und Messfehler waren in der Astronomie im 18. und 19. Jahrhundert ein verbreitetes Problem. Fisher erkannte das Chaos - oder die Varianz - die die Natur einem oder einer systematisch Experimentierenden aufzwingt. Die Nachfrage nach mehr Nahrung aufgrund des Bevölkerungswachstums und die Verfügbarkeit potenter Saatgutsorten und Düngemittel - beides dank wissenschaftlicher Experimente möglich - warfen die Frage auf, wie man [https://explorable.com/field-experiments Experimente unter Feldbedingungen] durchführen sollte. Die Durchführung von Experimenten im Labor stieß an ihre äußeren Grenzen, da Pflanzenwachstumsexperimente in den kleinen, engen Räumen eines Labors schwer durchführbar waren, und es wurde in Frage gestellt, ob die Ergebnisse tatsächlich in der realen Welt anwendbar waren. Daher verlagerten sich die Experimente buchstäblich ins Feld, mit [https://www.tutor2u.net/psychology/reference/field-experimentsme dramatischen Auswirkungen auf ihre Gestaltung, Durchführung und Ergebnisse]. Während die Laborbedingungen darauf abzielten, die Varianz zu minimieren - im Idealfall wurden die Experimente mit hoher Zuverlässigkeit durchgeführt -, wurde bei den neuen Feldexperimenten die Stichprobengröße erhöht, um die Variabilität - oder Unordnung - von Faktoren zu zähmen, die nicht kontrolliert werden konnten, wie z.B. subtile Veränderungen des Bodens oder des Mikroklimas. [https://en.wikipedia.org/wiki/Field_experiment#Examples Die Etablierung des Feldexperiments] wurde so zu einem Schritt in der wissenschaftlichen Entwicklung, aber auch in der industriellen Entwicklung. Die Wissenschaft trug direkt zur Effizienz der Produktion bei, im Guten wie im Schlechten. |

| + | Mehr Informationen zu Feldexperimenten finden Sie [[Field experiments|hier]]. | ||

== Vorhang auf für das natürliche Experiment == | == Vorhang auf für das natürliche Experiment == | ||

| Line 112: | Line 104: | ||

Auf Basis vielfältiger Diskussionen über Komplexität, [https://learningforsustainability.net/systems-thinking/ Systemdenken] und der Notwendigkeit, bestimmte Zusammenhänge tiefer zu verstehen, wurde die klassische Versuchsanordnung irgendwann mehr und mehr in Frage gestellt. Was aus der Entwicklung von [https://sustainabilitymethods.org/index.php/Interactions#The_field_experiment Feldexperimenten] hervorging, war angesichts der Komplexitätsreduktion ein fast genau entgegengesetzter Trend. Was lernen wir aus singulären Fällen? Wie gehen wir mit Fällen um, die signifikante Ergebnisse zeigen, aber nicht repliziert werden können? Und was lässt sich aus dem Design solcher Fallstudien ableiten? Ein berühmtes Beispiel aus ethnographischen Studien ist die [http://www.eisp.org/818/ Osterinsel]. Warum haben die Menschen dort einen Großteil ihrer Ressourcen in den Bau gigantischer Statuen gesteckt und damit ihre Gesellschaft an den Rand des Zusammenbruchs gebracht? Obwohl dies eine sicherlich faszinierende Frage ist, gibt es keine Nachbildungen der Osterinseln. Dies ist auf den ersten Blick ein sehr spezifisches und einzigartiges Problem, doch wird es oft als ein wichtiges Beispiel dafür angesehen, wie unnachhaltiges Verhalten zu einem Zusammenbruch der damaligen Zivilisation führte. Solche Bedingungen werden als [https://www.britannica.com/science/natural-experiment 'natürliche Experimente'] bezeichnet. | Auf Basis vielfältiger Diskussionen über Komplexität, [https://learningforsustainability.net/systems-thinking/ Systemdenken] und der Notwendigkeit, bestimmte Zusammenhänge tiefer zu verstehen, wurde die klassische Versuchsanordnung irgendwann mehr und mehr in Frage gestellt. Was aus der Entwicklung von [https://sustainabilitymethods.org/index.php/Interactions#The_field_experiment Feldexperimenten] hervorging, war angesichts der Komplexitätsreduktion ein fast genau entgegengesetzter Trend. Was lernen wir aus singulären Fällen? Wie gehen wir mit Fällen um, die signifikante Ergebnisse zeigen, aber nicht repliziert werden können? Und was lässt sich aus dem Design solcher Fallstudien ableiten? Ein berühmtes Beispiel aus ethnographischen Studien ist die [http://www.eisp.org/818/ Osterinsel]. Warum haben die Menschen dort einen Großteil ihrer Ressourcen in den Bau gigantischer Statuen gesteckt und damit ihre Gesellschaft an den Rand des Zusammenbruchs gebracht? Obwohl dies eine sicherlich faszinierende Frage ist, gibt es keine Nachbildungen der Osterinseln. Dies ist auf den ersten Blick ein sehr spezifisches und einzigartiges Problem, doch wird es oft als ein wichtiges Beispiel dafür angesehen, wie unnachhaltiges Verhalten zu einem Zusammenbruch der damaligen Zivilisation führte. Solche Bedingungen werden als [https://www.britannica.com/science/natural-experiment 'natürliche Experimente'] bezeichnet. | ||

| − | + | Aus einer bestimmten Perspektive ist unser ganzer Planet ein natürliches Experiment, und es ist auch aus statistischer Sicht ein Problem, dass wir keine Replikate haben, abgesehen von anderen Problemen und Unklarheiten, die sich aus solchen Einzelfallstudien ergeben, die jedoch oft auch in kleinerem Maßstab zunehmend relevant sind. Mit der Zunahme qualitativer Methoden in Vielfalt und Fülle und dem Drang, auch komplexe Systeme und Fälle zu verstehen, besteht eindeutig ein Bedarf an der Integration von Wissen aus natürlichen Experimenten. '''Aus statistischer Sicht sind solche Fälle schwierig und herausfordernd, da sie nicht reproduzierbar sind, aber das Wissen kann dennoch relevant, plausibel und gültig sein.''' Zu diesem Zweck proklamiere ich das Konzept der Nische, um zu veranschaulichen und zu konzeptualisieren, wie einzelne Fälle immer noch zur Produktion und zum Kanon des Wissens beitragen können. | |

| − | Aus einer bestimmten Perspektive ist unser ganzer Planet ein natürliches Experiment, und es ist auch aus statistischer Sicht ein Problem, | ||

Zum Beispiel die [https://academic.oup.com/rcfs/article/4/2/155/1555737#113865691 Finanzkrise von 2007], bei der viele Muster mit früheren Krisen vergleichbar waren, aber andere Faktoren anders waren. Daher ist diese Krise in Bezug auf einige Informationsebenen mit vielen früheren Faktoren und Mustern vergleichbar, aber auch in Bezug auf andere Dynamiken neu und nicht übertragbar. Wir haben jedoch aufgrund des Einzelfalls dieser Finanzkrise verstanden, dass bestimmte Konstrukte in unseren Finanzsystemen korrupt sind, wenn nicht gar inhärent fehlerhaft. Der Beitrag zur Weiterentwicklung der Finanzwelt ist daher unbestreitbar, auch soweit, dass viele Menschen darin übereinstimmen, dass die vorgenommenen Veränderungen sicherlich nicht ausreichen. | Zum Beispiel die [https://academic.oup.com/rcfs/article/4/2/155/1555737#113865691 Finanzkrise von 2007], bei der viele Muster mit früheren Krisen vergleichbar waren, aber andere Faktoren anders waren. Daher ist diese Krise in Bezug auf einige Informationsebenen mit vielen früheren Faktoren und Mustern vergleichbar, aber auch in Bezug auf andere Dynamiken neu und nicht übertragbar. Wir haben jedoch aufgrund des Einzelfalls dieser Finanzkrise verstanden, dass bestimmte Konstrukte in unseren Finanzsystemen korrupt sind, wenn nicht gar inhärent fehlerhaft. Der Beitrag zur Weiterentwicklung der Finanzwelt ist daher unbestreitbar, auch soweit, dass viele Menschen darin übereinstimmen, dass die vorgenommenen Veränderungen sicherlich nicht ausreichen. | ||

| − | Ein weiteres prominentes Beispiel für einen oder | + | Ein weiteres prominentes Beispiel für einen Einzelfall oder Phänomen ist die Covid-19-Pandemie. Während aus früheren Pandemien viel gelernt wurde, ist diese Pandemie anders, entwickelt sich anders und hat andere Auswirkungen. Die Auswirkungen auf unsere Gesellschaft und die Möglichkeit, aus dieser Pandemie zu lernen, sind jedoch unbestreitbar. Während klassische Experimente Wissen wie Bauern in einem Schachspiel entwickeln und Schritt für Schritt voranschreiten, gleicht eine Krise wie die Covid-19-Pandemie eher dem Pferd in einem Schachspiel, springt über größere Lücken, ist weniger vorhersehbar und sicherlich schwieriger zu bewältigen. Die Evolution des Wissens in einer vernetzten Welt erfordert oft einen eher singulären Ansatz als Ausgangspunkt. Dies ist besonders wichtig in den normativen Wissenschaften, wo zum Beispiel in der Naturschutzbiologie viele Forscher Lösungen durch singuläre Fallstudien angehen. Aus diesem Grund entstand die lösungsorientierte Agenda der Nachhaltigkeitswissenschaften, die diesem Umstand und darüber hinaus Rechnung trägt. |

[[File:Lueneburg 2030.jpg|thumb|left|Lüneburg 2030+ ist ein wunderbares Beispiel für eine Reihe von Realwelt-Eperimenten. Diese Karte bietet einen Überblick über die verschiedenen Experimente.]] | [[File:Lueneburg 2030.jpg|thumb|left|Lüneburg 2030+ ist ein wunderbares Beispiel für eine Reihe von Realwelt-Eperimenten. Diese Karte bietet einen Überblick über die verschiedenen Experimente.]] | ||

| Line 123: | Line 114: | ||

In dieser Hinsicht sind [https://journals.sagepub.com/doi/pdf/10.1177/0963662505050791 Realwelt-Experimente] die neueste Entwicklung in der Diversifizierung des Experimentierfeldes. Diese Art von Experimenten wird derzeit in der Literatur umfassend untersucht, doch ich erkenne in der verfügbaren Literatur bisher kein einheitliches Verständnis dessen, was Experimente aus der realen Welt sind. Diese Experimente können jedoch als eine Fortsetzung des Trends der natürlichen Experimente angesehen werden, bei denen eine lösungsorientierte Agenda versucht, eine oder mehrere Interventionen zu generieren, deren Wirkungen oft in Einzelfällen getestet werden, wobei die Bewertungskriterien jedoch bereits vor der Durchführung der Studie klar sind. Die meisten Studien haben dies bisher mit Nachdruck definiert; dennoch zeichnet sich die Entwicklung von Experimenten aus der realen Welt erst langsam ab. | In dieser Hinsicht sind [https://journals.sagepub.com/doi/pdf/10.1177/0963662505050791 Realwelt-Experimente] die neueste Entwicklung in der Diversifizierung des Experimentierfeldes. Diese Art von Experimenten wird derzeit in der Literatur umfassend untersucht, doch ich erkenne in der verfügbaren Literatur bisher kein einheitliches Verständnis dessen, was Experimente aus der realen Welt sind. Diese Experimente können jedoch als eine Fortsetzung des Trends der natürlichen Experimente angesehen werden, bei denen eine lösungsorientierte Agenda versucht, eine oder mehrere Interventionen zu generieren, deren Wirkungen oft in Einzelfällen getestet werden, wobei die Bewertungskriterien jedoch bereits vor der Durchführung der Studie klar sind. Die meisten Studien haben dies bisher mit Nachdruck definiert; dennoch zeichnet sich die Entwicklung von Experimenten aus der realen Welt erst langsam ab. | ||

| + | Für mehr Informationen zu Fallstudien und natürlichen Experimenten siehe [[Case studies and Natural experiments]]. | ||

== Experimente bis heute == | == Experimente bis heute == | ||

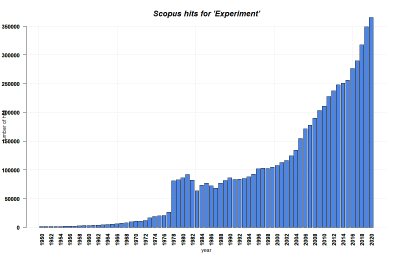

| + | [[File:Experiment Scopus.png|400px|thumb|right|'''SCOPUS-Treffer pro Jahr für 'Experiment' bis 2020.''' Suchbegriffe: 'Experiment' in Titel, Abstract, Keywords. Quelle: eigene.]] | ||

Unter dem Oberbegriff 'Experiment' werden somit unterschiedliche methodische Ansätze zusammengefasst. Während einfache Manipulationen wie medizinische Verfahren bereits in der Aufklärung als Experiment bekannt waren, gewann der Begriff 'Experiment' im Laufe des 20. Jahrhunderts an Bedeutung. Botanische Experimente wurden schon lange vorher durchgeführt, aber es waren die Agrarwissenschaften, die die notwendigen methodischen Entwürfe zusammen mit den geeigneten [[Bachelor Statistics Lecture|statistischen Analysen]] entwickelten und damit eine statistische Revolution auslösten, die in zahlreichen Wissenschaftsbereichen Wellen schlug. Die Varianzanalyse ([[ANOVA]]) wurde zum wichtigsten statistischen Ansatz zu diesem Zweck und ermöglichte die systematische Gestaltung von Versuchsanordnungen, sowohl im Labor als auch im landwirtschaftlichen Bereich. | Unter dem Oberbegriff 'Experiment' werden somit unterschiedliche methodische Ansätze zusammengefasst. Während einfache Manipulationen wie medizinische Verfahren bereits in der Aufklärung als Experiment bekannt waren, gewann der Begriff 'Experiment' im Laufe des 20. Jahrhunderts an Bedeutung. Botanische Experimente wurden schon lange vorher durchgeführt, aber es waren die Agrarwissenschaften, die die notwendigen methodischen Entwürfe zusammen mit den geeigneten [[Bachelor Statistics Lecture|statistischen Analysen]] entwickelten und damit eine statistische Revolution auslösten, die in zahlreichen Wissenschaftsbereichen Wellen schlug. Die Varianzanalyse ([[ANOVA]]) wurde zum wichtigsten statistischen Ansatz zu diesem Zweck und ermöglichte die systematische Gestaltung von Versuchsanordnungen, sowohl im Labor als auch im landwirtschaftlichen Bereich. | ||

| − | Während Psychologie, Medizin, Agrarwissenschaft, Biologie und später auch die Ökologie auf diese Weise in der Anwendung von Versuchsplänen und Studien gediehen, gab es auch eine zunehmende Anerkennung von Informationen, die [[Bias and Critical Thinking|Bias]] erzeugten oder die Ergebnisse anderweitig verzerrten. '''Die ANOVA wurde daher durch zusätzliche Modifikationen ergänzt, was schließlich zu fortgeschritteneren Statistiken führte, die in der Lage waren, sich auf verschiedene statistische Effekte zu konzentrieren'', und den Einfluss von Bias zu reduzieren, z.B. in Stichproben, statistischem Bias oder anderen Fehlern. Somit wurden [[Mixed-Effect Models]] zu einem fortgeschrittenen nächsten Schritt in der Geschichte der statistischen Modelle, der zu komplexeren statistischen Designs und Experimenten führte, bei denen immer mehr Informationen berücksichtigt wurden. Darüber hinaus führten meta-analytische Ansätze dazu, mehrere Fallstudien zu einem systematischen Überblick | + | Während Psychologie, Medizin, Agrarwissenschaft, Biologie und später auch die Ökologie auf diese Weise in der Anwendung von Versuchsplänen und Studien gediehen, gab es auch eine zunehmende Anerkennung von Informationen, die [[Bias and Critical Thinking|Bias]] erzeugten oder die Ergebnisse anderweitig verzerrten. '''Die ANOVA wurde daher durch zusätzliche Modifikationen ergänzt, was schließlich zu fortgeschritteneren Statistiken führte, die in der Lage waren, sich auf verschiedene statistische Effekte zu konzentrieren''', und den Einfluss von Bias zu reduzieren, z.B. in Stichproben, statistischem Bias oder anderen Fehlern. Somit wurden [[Mixed-Effect Models]] zu einem fortgeschrittenen nächsten Schritt in der Geschichte der statistischen Modelle, der zu komplexeren statistischen Designs und Experimenten führte, bei denen immer mehr Informationen berücksichtigt wurden. Darüber hinaus führten meta-analytische Ansätze dazu, mehrere Fallstudien zu einem systematischen Überblick zu kombinieren und zusammenzufassen. Dies war der Beginn eines integrativeren Verständnisses verschiedener Studien, die in einer [[Meta-Analysis|Meta-Analyse]] kombiniert wurden, wobei auch die unterschiedlichen Kontexte der zahlreichen Studien berücksichtigt wurden. Darüber hinaus konzentrierte sich die Forschung mehr und mehr auf ein tieferes Verständnis einzelner Fallstudien, wobei der spezifische Kontext des jeweiligen Falles stärker betont wurde. Solche Einzelfallstudien sind in der medizinischen Forschung seit Jahrzehnten von Wert, wo trotz des offensichtlichen Mangels an einem breiteren Beitrag häufig neue Herausforderungen oder Lösungen veröffentlicht werden. Solche medizinischen Fallstudien berichten über neue Erkenntnisse, auftauchende Probleme oder andere bisher unbekannte Falldynamiken und dienen oft als Ausgangspunkt für weitere Forschung. Aus so unterschiedlichen Ursprüngen wie [[System Thinking & Causal Loop Diagrams|Systemdenken]], Stadtforschung, [[Ethnography|Ethnographie]] und anderen Forschungsfeldern entstanden [[Living Labs & Real World Laboratories|Realwelt-Experimente]], die im alltäglichen sozialen oder kulturellen Umfeld stattfinden. Die starren Entwürfe von Labor- oder Feldexperimenten werden gegen ein tieferes Verständnis des spezifischen Kontexts und Falls eingetauscht. Während Experimente aus der realen Welt bereits vor einigen Jahrzehnten entstanden sind, beginnen sie erst jetzt, breitere Anerkennung zu finden. Gleichzeitig stellt die [https://www.vox.com/future-perfect/21504366/science-replication-crisis-peer-review-statistics Reproduzierbarkeitskrise] die klassischen Labor- und Feldexperimente in Frage, da man sich darüber im Klaren ist, dass viele Ergebnisse - zum Beispiel aus psychologischen Studien - nicht reproduziert werden können (auch wenn es [https://www.nature.com/articles/s41562-023-01749-9 neue Hinweise] darauf gibt, dass die Reproduzierbarkeit von Verhaltensstudien durch Maßnahmen für mehr Sorgfältigkeit verbessert werden kann). All dies deutet darauf hin, dass zwar ein großer Teil unseres wissenschaftlichen Wissens aus Experimenten stammt, dass es aber auch noch viel zu lernen gibt, auch über die Durchführung der Experimente selbst. |

---- | ---- | ||

[[Category: Normativity_of_Methods]] | [[Category: Normativity_of_Methods]] | ||

Latest revision as of 14:08, 7 March 2024

Quantitative - Qualitative

Deductive - Inductive

Individual - System - Global

Past - Present - Future

Note: This is the German version of this entry. The original, English version can be found here: Experiments and Hypothesis Testing. This entry was translated using DeepL and only adapted slightly. Any etymological discussions should be based on the English text.

Note: Dieser Eintrag stellt eine kurze Einführung zu Experimenten dar. Für weitere Informationen siehe Experiments, Case studies and Natural experiments und Field experiments.

Kurz und knapp: Dieser Eintrag stellt das Konzept von Hypothesen vor und zeigt, wie man sie systematisch testen kann.

Contents

Hypothesenentwicklung

Das Leben ist voller Hypothesen. Wir werden alle durch einen endlosen Fluss von Fragen verwirrt. Wir testen unsere Umgebung ständig auf mögliche "Was-wäre-wenn"-Fragen, die unseren Verstand überfordern, doch noch häufiger ist unser überladener Kopf nicht in der Lage, verallgemeinerbares Wissen zu produzieren. Dennoch hilft uns unser Gehirn dabei, unsere Umgebung zu filtern, auch indem es ständig Fragen - oder Hypothesen - prüft, damit wir die Herausforderungen, denen wir uns stellen, besser bewältigen können. Es sind nicht die wirklich großen Fragen, die uns jeden Tag beschäftigen, aber diese kleinen Fragen halten uns in Bewegung.

Haben Sie schon einmal in einem Restaurant das falsche Essen gewählt? Dann schreibt Ihr Gehirn eine kleine Notiz an sich selbst, und beim nächsten Mal wählen Sie etwas anderes aus. So können wir unsere Nische im Leben finden. Irgendwann jedoch begannen die Menschen, Muster in ihrer Umgebung zu beobachten und diese anderen Menschen mitzuteilen. Zusammenarbeit und Kommunikation waren unsere Mittel, um zu Gemeinschaften und viel später zu Gesellschaften zu werden. Das geht auf die Zeit vor den Anfängen des Menschen zurück und kann auch bei anderen Tieren beobachtet werden. Im Rahmen unserer Entwicklung wurde es zum Rückgrat unserer modernen Zivilisation - im Guten wie im Schlechten - als wir begannen, unsere Fragen systematisch zu testen. James Lind zum Beispiel führte einen dieser ersten systematische Ansätze auf See durch und schaffte es, eine Heilung für die Krankheit Skorbut zu finden, die den Seeleuten im 18. viele Probleme bereitet hatte.

Das Testen einer Hypothese

Konkrete Fragen, die in einer ersten Idee, einer Theorie, wurzeln, wurden so wiederholt getestet. Oder vielleicht sollte man besser sagen, dass diese Hypothesen mit Wiederholungen getestet wurden und die unsere Beobachtung störenden Einflüsse konstant gehalten wurden. Dies nennt man das Testen einer Hypothese: die wiederholte systematische Untersuchung einer vorgefassten Theorie, bei der während der Prüfung idealerweise alles konstant gehalten wird, außer dem, was untersucht wird. Während einige dies als die "wissenschaftliche Methode" bezeichnen, gefällt mir diese Bezeichnung nicht besonders, da sie impliziert, dass es sich um DIE wissenschaftliche Methode handelt, was sicherlich nicht stimmt. Dennoch war die systematische Prüfung der Hypothese und der daraus resultierende Erkenntnisprozess zweifellos eine wissenschaftliche Revolution (weitere Informationen finden Sie hier).

Wichtig in Bezug auf dieses Wissen ist die Vorstellung, dass eine bestätigte Hypothese darauf hinweist, dass etwas wahr ist, dass aber andere, bisher unbekannte Faktoren diese Hypothese später verfälschen können. Aus diesem Grund ermöglicht uns die Prüfung von Hypothesen eine Annäherung an das Wissen, wie viele argumentieren würden, mit einer gewissen Sicherheit, aber wir werden nie wirklich etwas wissen. Das scheint zwar etwas verwirrend, aber ein prominentes Beispiel kann dies vielleicht veranschaulichen. Bevor Australien entdeckt wurde, waren alle in Europa bekannten Schwäne weiß. Mit der Entdeckung Australiens, und zur Überraschung der damaligen Naturhistoriker*innen, wurden schwarze Schwäne entdeckt. Vor dieser Entdeckung hätte also jeder eine Hypothese aufgestellt: alle Schwäne sind weiß. Dann wurde Australien entdeckt, und die Welt veränderte sich oder zumindest das Wissen der westlichen Kulturen über Schwäne.

An diesem Punkt ist es wichtig zu wissen, dass es zwei Arten von Hypothesen gibt. Stellen wir uns vor, Sie nähmen an, es gäbe nicht nur weiße Schwäne auf der Welt, sondern auch schwarze Schwäne. Die Nullhypothese (H0) besagt, dass das nicht der Fall ist - alles bleibt so, wie wir es annahmen, bevor Sie mit Ihrer merkwürdigen Idee um die Ecke gekommen sind. Die Nullhypothese wäre also: alle Schwäne sind weiß. Die Alternativhypothese (H1) fordert diese Nullhypothese nun heraus: es gibt auch schwarze Schwäne. Das haben Sie ja behauptet. Wir gehen aber nicht sofort davon aus dass das, was Sie behaupten, auch stimmt, also machen wir es zur Alternativhypothese. Jetzt wollen wir herausfinden, ob es eine ausreichende Beweislast zugunsten der Alternativhypothese gibt. Hierfür testen wir die Wahrscheinlichkeit, dass die H0 wahr ist, um zu entscheiden, ob wir H0 akzeptieren oder sie verwerfen und uns stattdessen für die H1 entscheiden. Diese Entscheidung geht Hand in Hand: wenn wir eine der beiden Hypothesen akzeptieren, weisen wir gleichzeitig die andere zurück. Achtung: Hypothesen kann man nur zurückweisen, nicht aber basierend auf Daten bestätigen. Wenn es heißt, dass eine Hypothese 'akzeptiert' oder 'verifiziert' oder 'bewiesen' wird, heißt das nur, dass die Alternative nicht unterstützt werden kann, und dass wir deshalb bei der wahrscheinlicheren Hypothese bleiben.

Fehler beim Testen einer Hypothese

Beim Testen von Hypothesen können zwei verschiedene Fehler auftreten. Der falsch positive ("Fehlertyp I") und der falsch negative ("Fehlertyp II"). Wenn ein*e Ärzt*in bei einer Person eine Schwangerschaft diagnostiziert und diese Person nicht schwanger ist, handelt es sich um einen typischen falsch-positiven Fehler. Der*die Ärzt*in hat behauptet, dass die Person schwanger ist, was nicht der Fall ist. Umgekehrt ist es ein typischer falsch-negativer Fehler, wenn der*die Ärzt*in bei einer Person diagnostiziert, dass sie nicht schwanger ist, es aber tatsächlich ist - ein typischer falsch-negativer Fehler. Jede*r kann für sich selbst beurteilen, welche Art von Fehler gefährlicher ist. Dennoch sind beide Fehler zu vermeiden. Während der Corona-Krise wurde dies zu einem wichtigen Thema, da viele der Tests oft falsch waren. Wenn jemand Corona Symptome zeigte, aber negativ getestet wurde, war es ein falsches Negativ. Dies hängt anscheinend vom Zeitpunkt der Untersuchung und den jeweiligen Tests ab. Antikörpertests sind nur relevant, nachdem jemand Corona hatte, aber manchmal finden auch diese keine Antikörper. Bei einem aktiven Fall kann nur eine PCR eine Infektion bestätigen, aber die Entnahme einer Probe ist trickreich, daher gab es auch hier einige falsch-negative Ergebnisse. Falsch-positive Ergebnisse sind jedoch sehr selten, da die Fehlerquote des Tests auf dieser Seite sehr gering ist. Dennoch kam es manchmal vor, dass Proben verwechselt wurden. Selten, aber es kam vor, und sorgte für großes Aufsehen in den Medien.

Wissen verändert sich mit der Zeit

In der modernen Wissenschaft wird große Sorgfalt darauf verwendet, Hypothesen zu konstruieren, die systematisch fundiert sind, was bedeutet, dass schwarze Schwäne nicht zu erwarten sind, aber manchmal nicht verhindert werden können. Ein Beispiel ist die Frage, ob ein Medikament für Schwangere geeignet ist. Aus ethischen Gründen wird dies kaum getestet, was in der Vergangenheit schwerwiegende negative Auswirkungen hatte. Das Wissen darüber, wie sich ein bestimmtes Medikament auf Schwangere auswirkt, beruht daher oft auf Erfahrungen, wird aber nicht systematisch untersucht. Zusammengenommen werden Hypothesen zu einer Grundlage der modernen Wissenschaft, obwohl sie nur ein Konzept innerhalb des breiten Kanons wissenschaftlicher Methoden darstellen. Die Abhängigkeit von deduktiven Ansätzen hat in der Vergangenheit ebenfalls Probleme aufgeworfen und kann indirekt dazu führen, dass eine Mauer zwischen dem durch induktive vs. deduktive Ansätze geschaffenen Wissen errichtet wird.

Ein Gegenmittel für COVID-19

Ein bekanntes Beispiel für strenge Experimente sind klinische Studien, die fast alle Impfstoffe, so wie auch die Impfstoffe gegen Covid-19, durchlaufen. Diese Studien testen sehr viele Hypothesen. Ist der Impfstoff für die Menschen sicher, gibt es keine Nebenwirkungen, allergische Reaktionen oder andere schweren medizinischen Probleme? Erzeugt der Impfstoff eine Immunantwort? Und wirkt er auf verschiedene Altersgruppen oder andere Gruppen unterschiedlich? Um diese Strategien sicher zu testen, haben sich in den letzten Jahrzehnten klinische Studien als Goldstandard in modernen Experimenten herauskristallisiert. Viele mögen die moderne Wissenschaft kritisieren und vieles von dem in Frage stellen, was die Wissenschaft getan hat, um nicht nur zu einer positiven Entwicklung in unserer Gesellschaft beizutragen. Dennoch verdanken viele von uns ihr Leben solchen klinischen Versuchen - der sicheren und soliden Prüfung wissenschaftlicher Hypothesen unter sehr reproduzierbaren Bedingungen. Ein großer Teil der modernen Medizin, der Psychologie, der Produkttests und auch der Landwirtschaft verdankt ihre Auswirkungen auf unsere Gesellschaften dem Experiment. Im Nachhinein betrachtet können Impfungen als der sicherste Weg angesehen werden, die Covid-19-Pandemie zu beenden. Wir haben nicht nur diese Hypothese, sondern waren auch in der Lage sie in einem bestimmten, begrenzten Zeitrahmen bis heute zu testen. Die wissenschaftlichen Studien zeigen in eine klare Richtung, aber es gibt immer noch langfristigere Untersuchungen für diese Pandemie, die weiterhin unsere Hypothese untersuchen.

Key messages

- Das Testen einer Hypothese ist die wiederholte systematische Untersuchung einer vorgefassten Idee durch Beobachtung.

- Es gibt eine Unterscheidung zwischen der Nullhypothese (H0), die wir zu verwerfen versuchen, und der Alternativhypothese (H1).

- Es gibt zwei verschiedene Fehler, die auftreten können: falsch positiv ("Fehlertyp I") und falsch negativ ("Fehlertyp II").

Validität

Validität leitet sich vom lateinischen Wort "validus" ab, das mit "stark" übersetzt wird. Es handelt sich somit um ein zentrales Konzept innerhalb der Hypothesenprüfung, da es qualifiziert, inwieweit eine Hypothese wahr ist. Seine Bedeutung sollte nicht mit der Reliabilität verwechselt werden, die angibt, ob bestimmte Ergebnisse konsistent oder, mit anderen Worten, reproduzierbar sind. Die Validität gibt vielmehr an, inwieweit eine Hypothese bestätigt werden kann. Folglich ist sie zentral für den deduktiven Ansatz in der Wissenschaft; mit anderen Worten: sie sollte nicht über diese Denkweise hinaus missbraucht werden. Die Validität ist daher stark mit der Argumentation verbunden, weshalb sie die Gesamtstärke des Ergebnisses eines statistischen Resultats angibt.

Wir sollten uns jedoch bewusst sein, dass die Validität den gesamten Prozess der Anwendung von Statistik umfasst. Validität erstreckt sich von der Postulierung der ursprünglichen Hypothese über das methodische Design, die Wahl der Analyse und schließlich bis zur Interpretation. Die Validität ist also kein "alles oder nichts". Stattdessen müssen wir die verschiedenen Ansätze und Geschmacksrichtungen der Validität kennen lernen, und nur die Erfahrung mit verschiedenen Datensätzen und Situationen wird es uns ermöglichen zu beurteilen, ob ein Ergebnis gültig ist oder nicht. Man kann zum Beispiel vorhersagen, dass es wahrscheinlicher ist, dass jemand gähnt, wenn andere Personen in der Umgebung auch gähnen, da Gähnen ansteckend ist. Das sagt aber nichts darüber aus, wie müde jemand ist oder warum. Gähnen könnte daher auch nur dann ein valides Maß für Müdigkeit sein, wenn Menschen alleine sind. Ob Gähnen ein valides Maß für Müdigkeit ist, hängt also vom Kontext ab und ist generell nicht sehr valide. Folglich ist die Validität der Frage, ob die Bestätigung einer Hypothese vernünftig ist, viel schwieriger zu beantworten, denn wir könnten voreingenommen oder schlichtweg nicht dazu in der Lage sein, den Kontext zu verstehen, wenn wir eine Studie erstellt haben. Nehmen Sie sich Zeit, um etwas über die Validität zu lernen, und nehmen Sie sich noch mehr Zeit, um Erfahrungen darüber zu sammeln, ob ein Ergebnis valide ist.

Reliabilität

Reliabilität ist eines der Schlüsselkonzepte der Statistik. Sie ist definiert als die Konsistenz eines bestimmten Maßes. Eine zuverlässige Messung liefert also vergleichbare Ergebnisse unter den gleichen Bedingungen. Die Reliabilität gibt Ihnen eine Vorstellung davon, ob Ihre Analyse unter den gegebenen Bedingungen genau und auch reproduzierbar ist. Wir haben bereits gelernt, dass die meisten, wenn nicht sogar alle Maße in der Statistik, konstruiert sind. Reliabilität ist von zentraler Bedeutung, da wir überprüfen können, ob unsere konstruierten Maße uns auf den richtigen Weg bringen. Mit anderen Worten, die Reliabilität ermöglicht es uns zu verstehen, ob unsere konstruierten Maße funktionieren.

Die Frage der Reproduzierbarkeit, die mit der Reliabilität verbunden ist, ist ein zentraler Aspekt der modernen Wissenschaft. Reliabilität ist daher das Konzept, das mindestens mehrere Komponenten enthält.

1. Das Ausmaß und die Komplexität des Maßes, das wir in unsere Analyse einbeziehen. Zwar kann im Allgemeinen nicht davon ausgegangen werden, dass extrem konstruierte Maße wie das BIP oder der IQ weniger zuverlässig sind als weniger konstruierte, aber wir sollten dennoch Occams Rasiermesser berücksichtigen, wenn wir über die Zuverlässigkeit von Maßen nachdenken, d.h. ihre Konstrukte kurz und einfach halten.

2. Relevant für die Reliabilität ist die Frage nach unserer Stichprobe. Wenn sich die äußeren Bedingungen der Stichprobe ändern, kann die Reliabilität aufgrund neuer Informationen abnehmen. Ein einfaches Beispiel wären wieder Schwäne. Wenn wir feststellen, dass es nur weiße Schwäne gibt, ist diese Hypothese zuverlässig, solange es nur weiße Schwäne in der Stichprobe gibt. Wenn sich jedoch die äußeren Bedingungen ändern - zum Beispiel wenn wir schwarze Schwäne in Australien entdecken - nimmt die Reliabilität unserer ersten Hypothese ab.

3. Darüber hinaus kann auch die Probenahme beeinträchtigt werden. Wenn die Beprobung von mehreren Beobachtern durchgeführt wird, kann eine Verringerung der Reliabilität durch die Unterschiede der jeweiligen Beobachtenden erklärt werden.

4. Wir müssen erkennen, dass unterschiedliche methodische Ansätze - oder in unserem Fall statistische Tests - aus unterschiedlichen Reliabilitätsmaßen bestehen können. Daher könnte sich das statistische Modell unserer Analyse direkt in unterschiedlichen Reliabilitäten niederschlagen. Ein einfaches Beispiel, um dies etwas besser zu erklären, ist der Ein-Stichproben-Test mit einer perfekten Münze. Dieser Test sollte funktionieren, aber er funktioniert nicht mehr, wenn die Münze verzerrt ist. Dann müssen wir eine neue Methode/Modell in Betracht ziehen, um dies zu erklären (nämlich den "Zwei-Stichproben-Test"). Wichtig ist, sich daran zu erinnern: Die Wahl Ihrer Methode/Modell hat einen Einfluss auf Ihre Testergebnisse.

5. Der letzte Aspekt der Reliabilität hängt mit unserer theoretischen Grundlage selbst zusammen. Wenn unsere zugrundeliegende Theorie revidiert oder geändert wird, kann dies die Zuverlässigkeit unserer Ergebnisse insgesamt beeinträchtigen. Es ist wichtig, dies hervorzuheben, da wir innerhalb einer gegebenen statistischen Analyse eine insgesamt bessere theoretische Grundlage haben könnten, das statistische Maß der Reliabilität jedoch niedriger sein könnte. Dies ist eine Quelle ständiger Verwirrung unter Statistik-Lernenden. Zum Beispiel versuchen Ökonomen immer noch, wirtschaftliche Dynamiken auf Basis des Bruttoinlandsproduktes zu modellieren. Wenn wir diese Annahme hin zu einer differenzierteren Theorie erneuern, könnte unser Modell schlechter funktionieren, aber wir würden die wirtschaftlichen Dynamiken trotzdem weniger falsch verstehen.

Die Frage, wie zuverlässig eine statistische Analyse oder besser das Ergebnis einer wissenschaftlichen Studie ist, ist meiner Erfahrung nach die Quelle endloser Debatten. Es gibt kein Maß der Reliabilität, das von allen akzeptiert wird. Stattdessen entwickelt sich die Statistik immer noch weiter, und die Maße der Zuverlässigkeit ändern sich. Auch wenn dies auf den ersten Blick verwirrend erscheint, sollten wir zwischen Ergebnissen, die extrem reliabel sind, und Ergebnissen, die in Bezug auf die Reliabilität geringer sind, unterscheiden. Ergebnisse aus der harten Wissenschaft wie Physik zeigen oft eine hohe Reliabilität, wenn es um statistische Tests geht, während weiche Wissenschaften wie Psychologie und Wirtschaft am unteren Ende der Reliabilität zu finden sind. Das ist keine normative Beurteilung, da die moderne Medizin oft Ergebnisse liefert, die zuverlässig sind, aber nur gerade so. Denken Sie an die Krebsforschung. Die meisten aktuellen Durchbrüche verändern das Leben einiger weniger Prozent der Patient*innen, und es gibt kaum einen Durchbruch, der einen größeren Teil der Patient*innen betrifft. Wir müssen daher die Zuverlässigkeit in der Statistik als ein bewegliches Ziel akzeptieren, und es hängt sehr stark vom Kontext ab, ob ein Ergebnis eine hohe oder niedrige Zuverlässigkeit hat.

Unsicherheit

Im antiken Griechenland gab es im Wesentlichen zwei Arten von Wissen. Die erste war das metaphysische, das sehr vielfältig war und von manchen vielleicht als vage bezeichnet wird. Die zweite war das physikalische oder besser mathematische Wissen, das recht präzise und ebenfalls vielfältig war. Mit dem Aufkommen irrationaler Zahlen im Mittelalter und der Kombination mit dem Testen von Hypothesen in der Aufklärung wurde jedoch die Unsicherheit geboren. Durch größere Stichproben, d.h. durch die Finanzbuchhaltung und durch wiederholte Messungen in der Astronomie, Biologie und anderen Wissenschaften, wurde ein gewisser Mangel an Präzision in den empirischen Wissenschaften deutlich. Wichtiger noch, Fluktuation, Modifikationen und andere Fehlerursachen wurden offensichtlich. Die weichen Wissenschaften waren auf dem Vormarsch, was eine deutlichere Erkennung von Fehlern in der wissenschaftlichen Analyse und Argumentation erforderte.

Während die Validität alles von der Theoriebildung bis zur endgültigen Bestätigung umfasst, beschäftigt sich die Unsicherheit nur mit der methodologischen Dimension des Hypothesentests. Beobachtungen können fehlerhaft sein, Messungen können falsch sein, eine Analyse kann verzerrt und falsch ausgewählt sein, aber das ist es zumindest, was uns die Unsicherheit sagen kann. Unsicherheit ist daher ein Wort für alle Fehler, die innerhalb einer methodologischen Anwendung gemacht werden können. Besser noch, Unsicherheit kann uns somit den Unterschied zwischen einem perfekten Modell und unseren empirischen Ergebnissen aufzeigen. Die Unsicherheit ist wichtig, um zu erkennen, wie gut unsere Hypothese oder unser Modell durch empirische Daten bestätigt werden kann, und alle damit verbundenen Messfehler und Fehlauswahlen in der Analyse.

Was die Unsicherheit so praktisch macht, ist die Tatsache, dass viele statistische Analysen über ein Maß zur Quantifizierung der Unsicherheit verfügen, und durch wiederholte Stichproben können wir so den so genannten "Fehler" unseres statistischen Tests abschätzen. Das Konfidenzintervall ist ein klassisches Beispiel für eine solche Quantifizierung eines Fehlers eines statistischen Ergebnisses. Da es eng mit der Wahrscheinlichkeit verbunden ist, kann uns das Konfidenzintervall die Wahrscheinlichkeit sagen, mit der unsere Ergebnisse reproduzierbar sind. Dies klingt zwar wie ein kleines Detail, ist aber in der modernen Statistik von enormer Bedeutung. Die Unsicherheit erlaubt es uns, zu quantifizieren, ob eine bestimmte Analyse zuverlässig wiederholt werden kann und das Ergebnis unter vergleichbaren Bedingungen relevant sein kann.